Conclusions cohérentes

Modèle de cosmologie offrant des conclusions plus cohérentes et convaincantes.

[1]

Ici le mot entropie est utilisé dans le sens quantification d’information.À l'heure actuelle, l'entropie est perçue

comme en constante augmentation dans le modèle standard, même si les physiciens

se demandent si celle-ci serait perdue dans les trous noirs. Selon cette étude,

l'entropie serait en effet détruite dans les trous noirs, cependant, elle

renaitrait au travers d’une nucléosynthèse qui se produirait essentiellement

dans les nébuleuses, ceci serait à l’origine d’un effet cyclique constant.

[*] L'auteur tiens a citer la conférence d'Hubert Reeves ayant eu lieu parc de la Villette en 2014, qu'il a bien entendu suivie avec intérêt, dont le titre était "Les cendres du Big bang".

[2] JWST : Le James Webb (JWST, pour l’anglais James Webb Space Télescope) est un télescope spatial servant d’observatoire fonctionnant principalement dans l’infrarouge, développé par la NASA avec la participation de l’Agence spatiale européenne (ESA) et de l’Agence spatiale canadienne (ASC)

[3]Ces informations sont tirées du livre « Le roman du big bang » de Simon Singh. L’acronyme « CMB » correspond au fond diffus cosmologique.

[4] La dénomination « mur de Planck » désigne un âge de l’univers, plus précisément à savoir environ 10-44 secondes, au-delà de laquelle la physique telle qu’on la connaît ne peut plus s’appliquer.

[5] Science et avenir, Comment-se-sont-formes-les-trous-noirs-les-plus-massifs-de-l-univers, le 11.03.2021 à 10h52

[1] La liste des paradoxes décrits ici est très réduite, elle correspond cependant a ce qui est le plus accessible au grand public

[6] 1801.05472] « Décalage vers le rouge électromagnétique dans les cosmologies anisotropes » (arxiv.org). Publié le : 16/01/2018

[7] Données extraites de la conférence « Expansion de l’Univers et controverse cosmologique », Louise Breuval 17 nov 2022

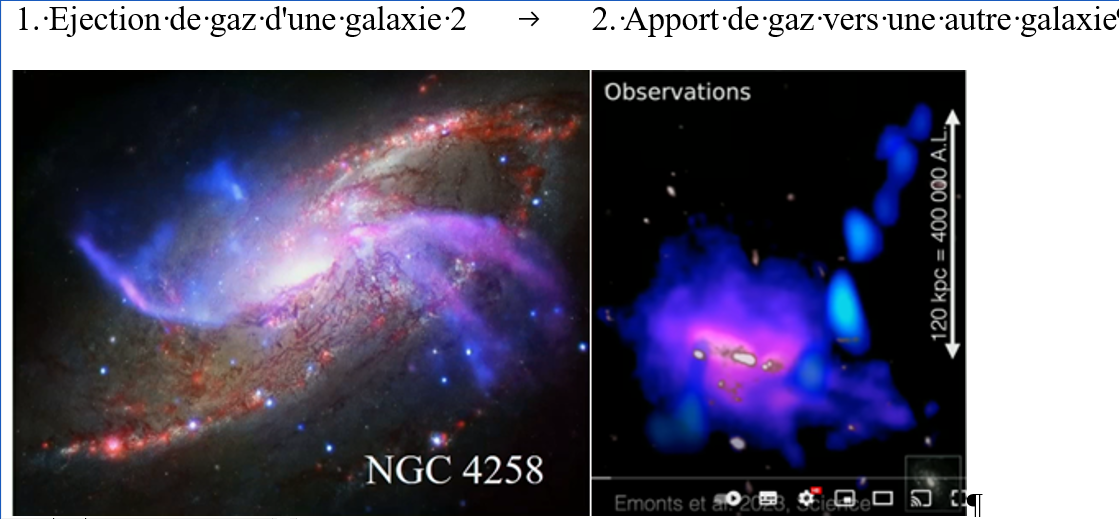

[8] Dans le modèle standard, on considère des scénarios à même de réduire la taille

des galaxies, la principale étant la rétroaction des supernovas, citons ci-dessous

l’état de l’art :

· Lorsqu'une étoile massive explose en supernova, elle libère une grande quantité d'énergie sous forme de lumière, de particules et de gaz chaud.

· Cette énergie peut expulser le gaz interstellaire hors de la galaxie, ralentissant ou empêchant la formation de nouvelles étoiles.

[9] Un champ est dit scalaire s’il est associé à une grandeur physique décrite par une valeur numérique, sans direction.

[10][2308.03837] émission radio d’un trou noir $z = 10,3 $ en UHZ1. Arxiv 11 sept. 2023

[11][2410.05891] Trous noirs primordiaux supermassifs pour les GHZ9 et UHZ1 observées par le JWST. Arxiv 8 octobre 2024

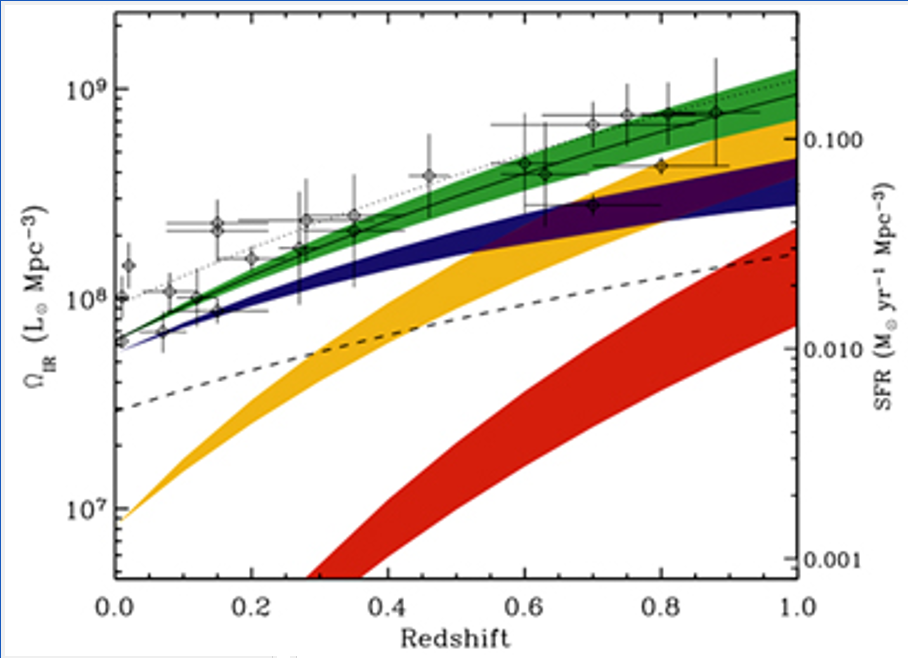

[12] L’Univers lointain et la formation stellaire (herschel.fr)

[13] https://fr.wikipedia.org/wiki/NGC_1277, mise ajour 7 janvier 2024 à 17h56

[14] Les astronomes détectent le sursaut radio rapide le plus lointain à ce jour, communiquer de presse, du 19 octobre 2023.

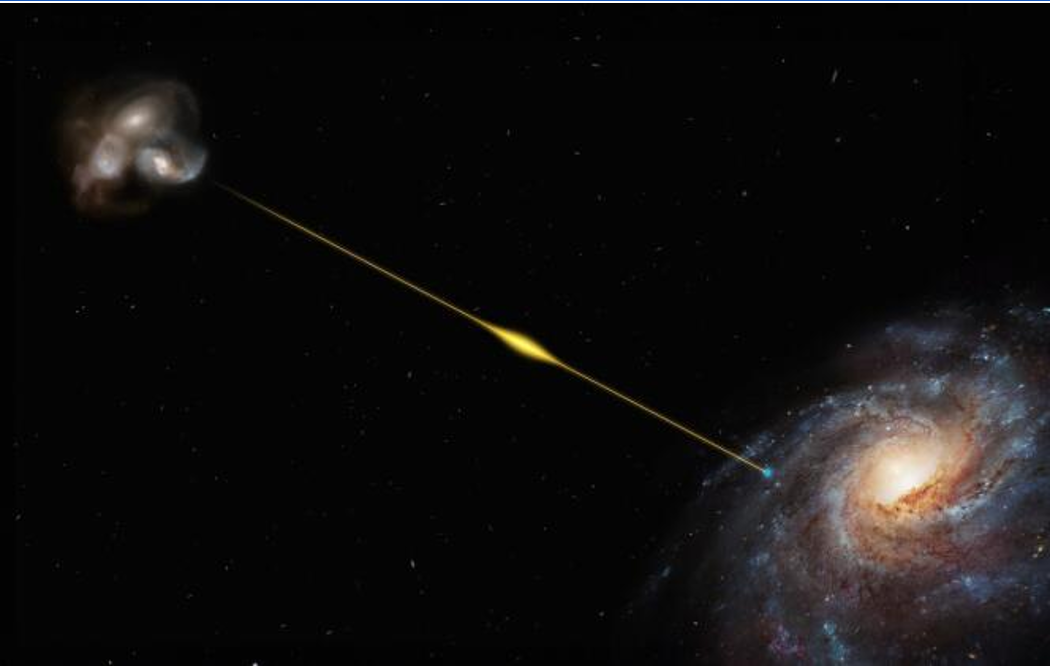

[15] FRB : Fast Radio Burst, en Français sursaut radio rapide (SRR). Correspondre à des pics d’ondes radios cosmiques de très haute intensité, de l’ordre de la milliseconde à 3 secondes.

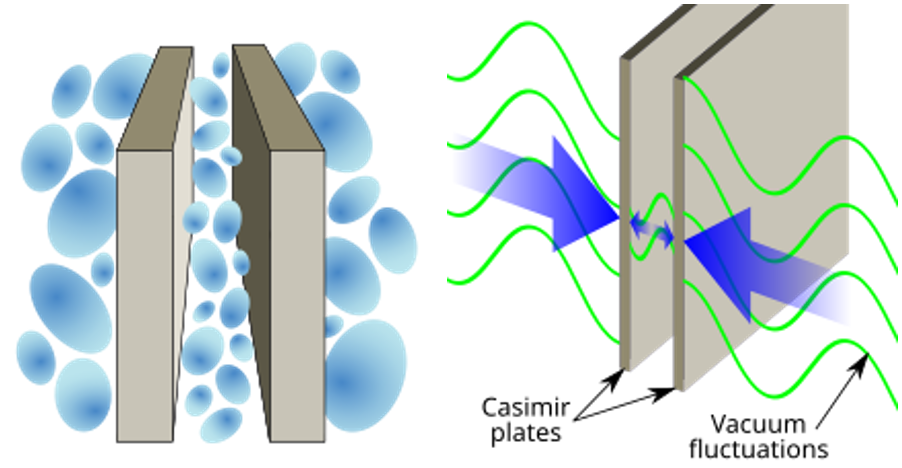

[16] https://fr.wikipedia.org/wiki/Effet_Casimir. L’effet Casimir est dû aux fluctuations du champ électromagnétique, décrit par la théorie de l’électrodynamique

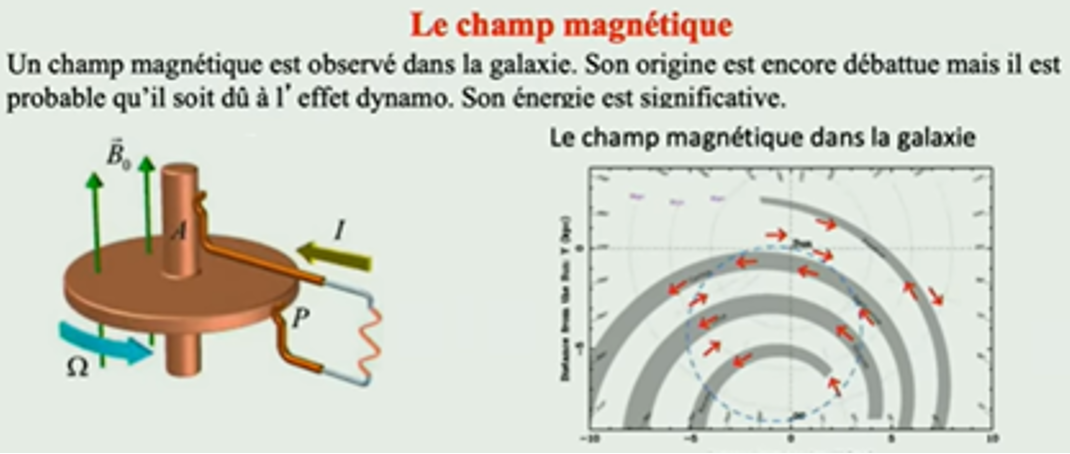

[17] Les champs magnétiques façonnent les galaxies spirales comme la Voie lactée, Futura Science le 11 déc. 2019

[18] Des astronomes détectent enfin un trou noir « poids-moyen » - Sciences et Avenir le 11/07/2024

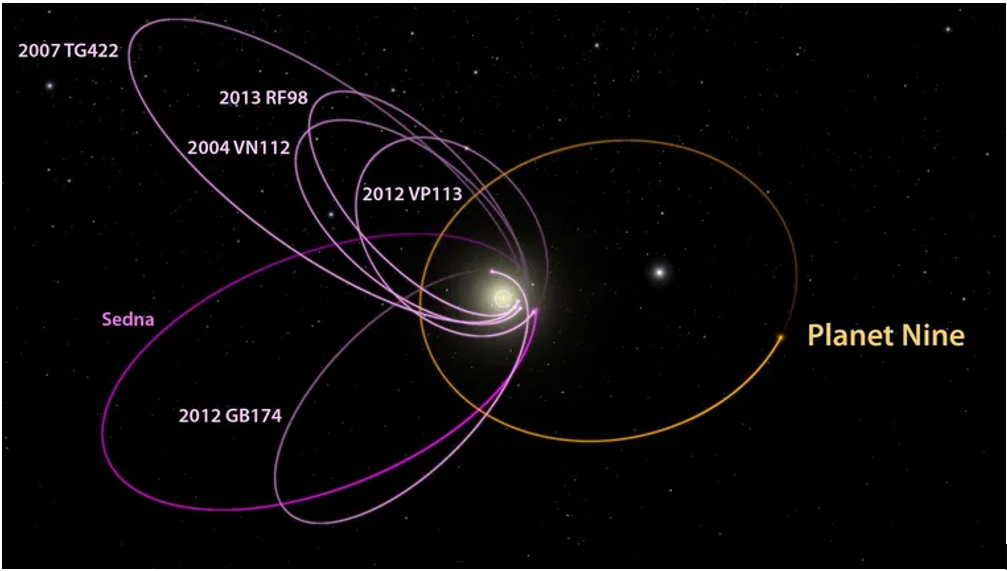

[20] https://www.rtbf.be/article/et-si-la-planete-9-n-existait-pas-11044623

[21] https://www.sciencesetavenir.fr/espace/univers/lhs3154b-la-planete-qui-ne-devrait-pas-exister_175381

E=mc2

[22] NDA : Cette notion de transformation onde-particule se base en partie sur les notions de la dialectique de Hegel, un corps, soumis à des contraintes, finis par opérer une transformation qualitative.

[23]https://www.techno-science.net/actualite/enveloppe-temperature-inimaginable-entoure-notre-galaxie-vient-elle-N26208.html

[24] Dans les premiers temps de l'Univers, le temps paraît s'écouler cinq fois plus lentement. Géo, le 09/07/2023 à 7h38.

[25]https://www.sciencesetavenir.fr/espace/voie-lactee/trou-noir-supermassif-sagittarius-a-des-scientifiques-retrouvent-l-echo-d-un-festin-cosmique-datant-de-200-ans_172066.

[26] Techno-Science.net « Des astronomes détectent d’inexplicables sursauts radio ». Le 28/10/2023

[27] Phonandroid.com, « Il y a eu une immense explosion dans l'espace, mais on ne sait pas pourquoi ». Par Thomas Povéda Le 09/10/2023. Article inspiré de arXiv :2307.01771v2, 3 octobre 2023

[28]Phonandroid.com, « Il y a eu une immense explosion dans l'espace, mais on ne sait pas pourquoi ». Par Thomas Povéda Le 09/10/2023. Article inspiré de arXiv :2307.01771v2, 3 octobre 2023

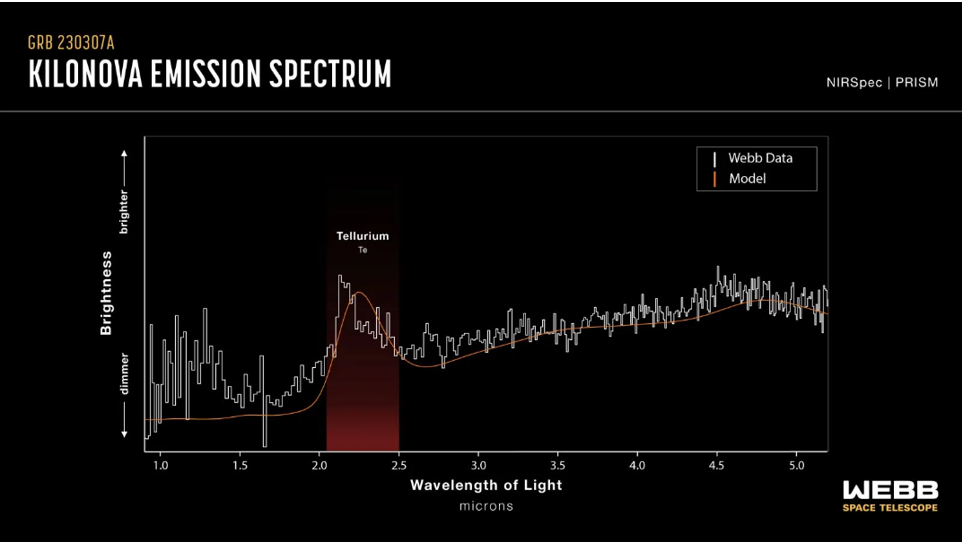

[29] Observatoire de Paris.psl.eu Première détection d’un élément lourd à 52 protons dans une fusion d’étoiles. Publié le 13 novembre 2023

[30] Une particule d'ultra haute énergie dont l'origine est inconnue a été détectée - Sciences et Avenir.

Vague scélérate : L'interférence de deux ondes. Lorsqu'elles sont en phase, les deux ondes créent une interférence constructive, produisant une onde de plus grande amplitude.

[31]https://issues.fr/interactions-neutrino-photons-percer-les-mysteres-de-la-physique-des-particules/

Figure 1 : La galaxie massive ZF-UDS-7329 © NASA/Cover Images/SIPA Valisoa Rasolofo & J. Paiano·23 février 2024

Figure 2 Source Ciel & espace, no 590, août-septembre 2023

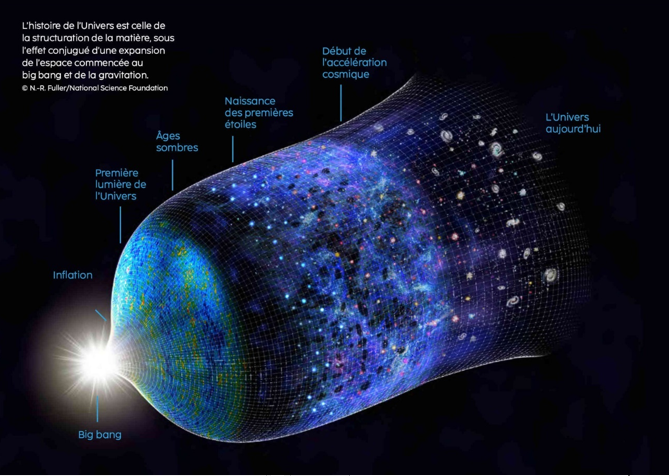

Figure 3 Equation de la relativité générale

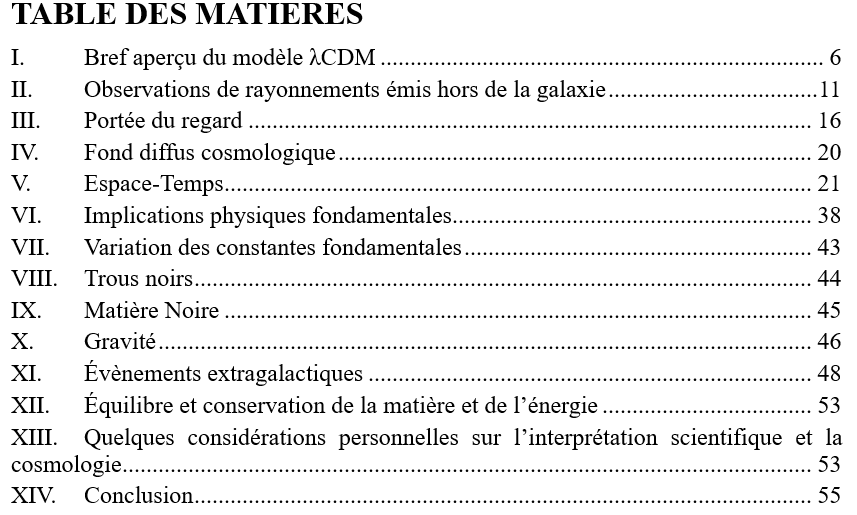

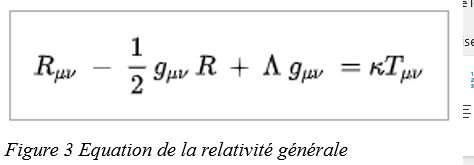

Figure 4 Source NewScientist : How redshift colours our view of the history of the universe, 14 october 2015/

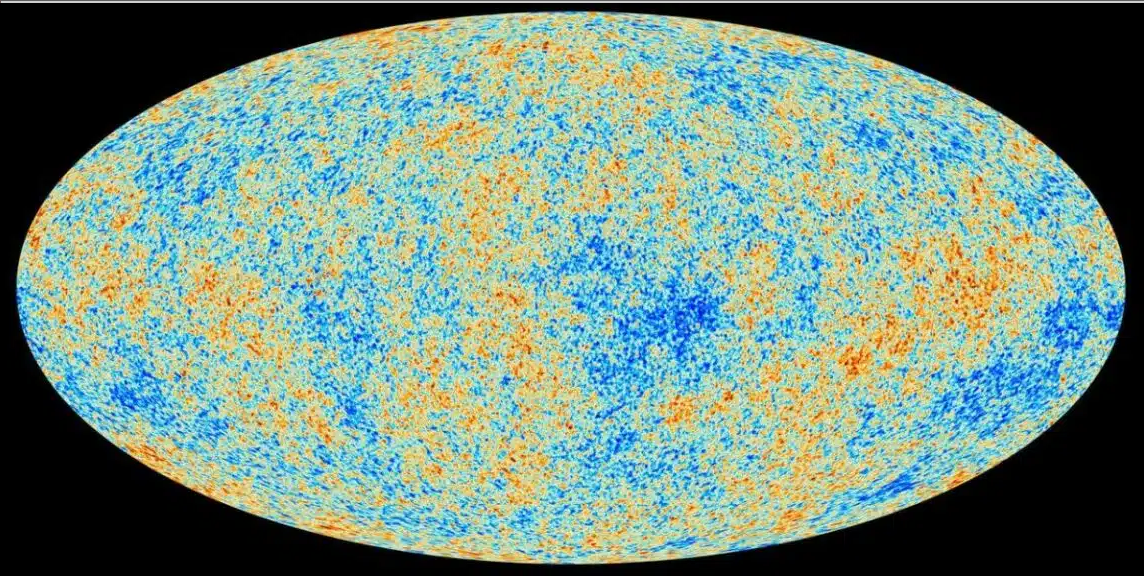

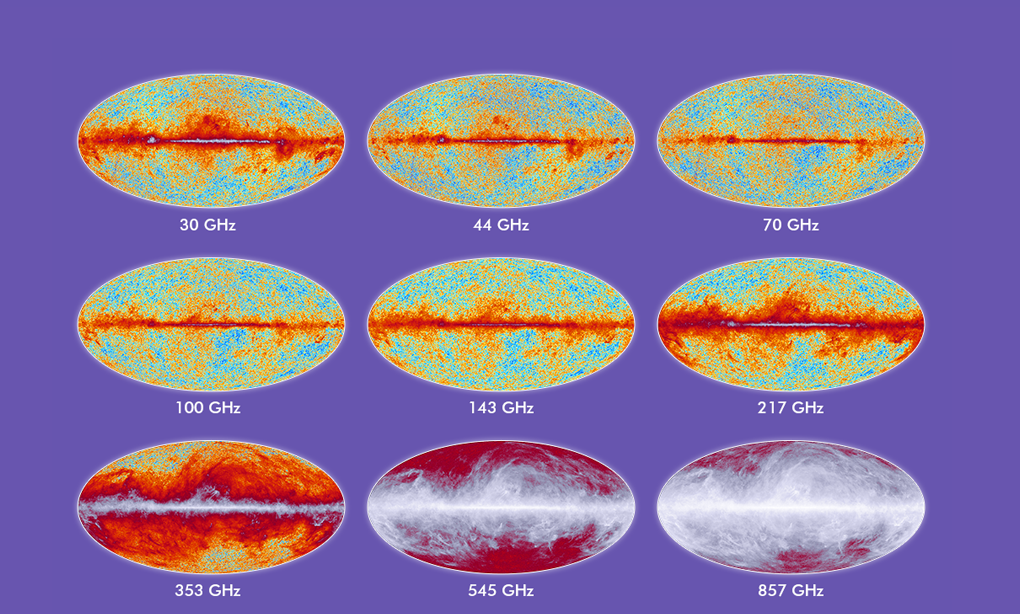

Figure 5 Science post : Qu’est-ce que le fond diffus cosmologique, et pourquoi est-il aussi important. Brice Louvet, expert espace et sciences 7 juillet 2023, 16 h 23 min

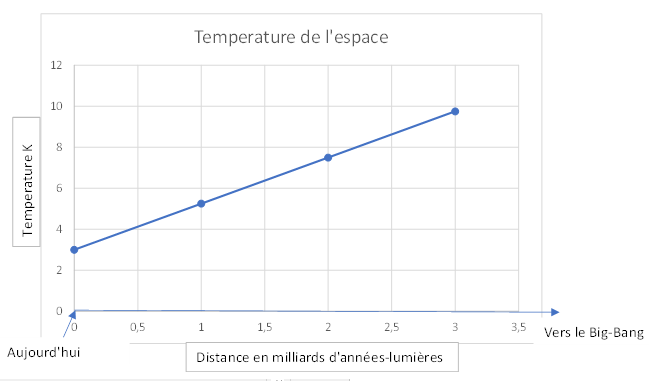

Figure 6 Mesure des corps les plus froids selon les âges d’observation, illustration de l’auteur inspirée de « La Crédibilité de la théorie du big bang » Hubert Reeves, 21 nov. 2014

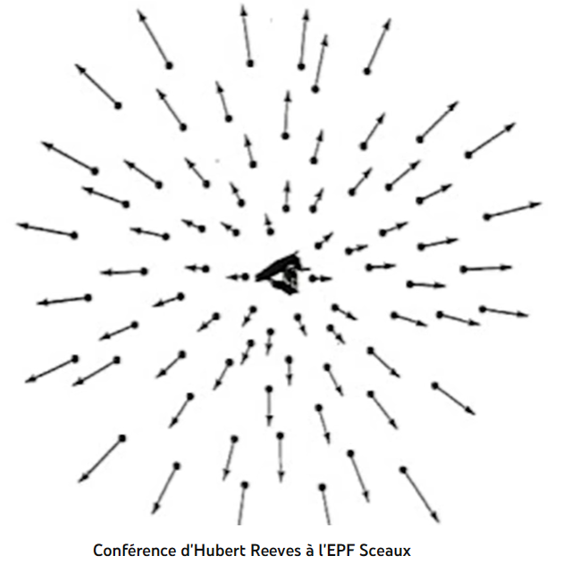

Figure 7 Illustration de conférence « L'Avenir de la vie sur Terre », Le 27 avril 2017

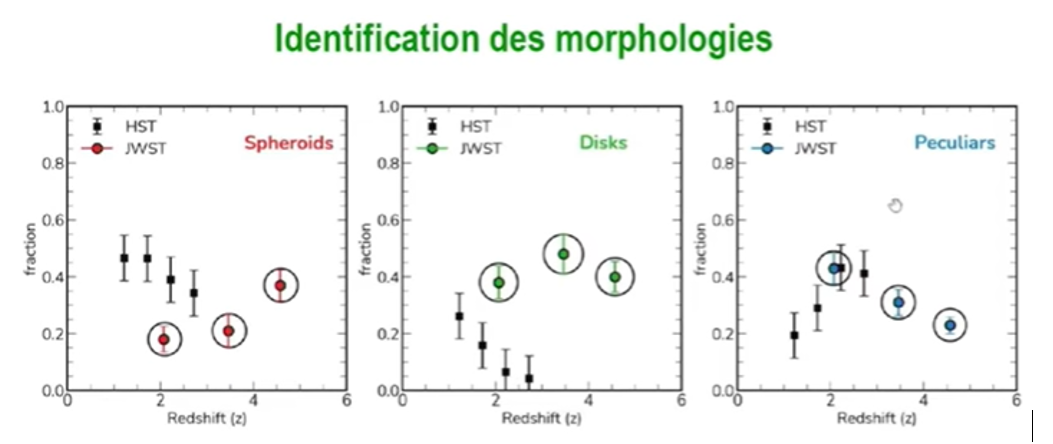

Figure 8 Les galaxies primordiales avec le télescope James Webb ». Société astronomique de France, Mercredi 8 février 2023 à 19h

Figure 9 sciencepost.fr image du télescope Webb de l’amas de galaxies SMACS 0723. Les premières galaxies de l’Univers sont étonnamment brillantes. Par Brice Louvet. 10 novembre 2023

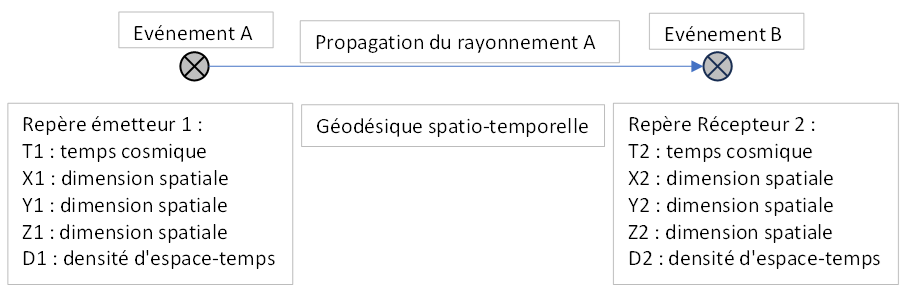

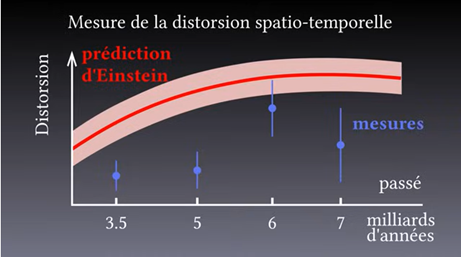

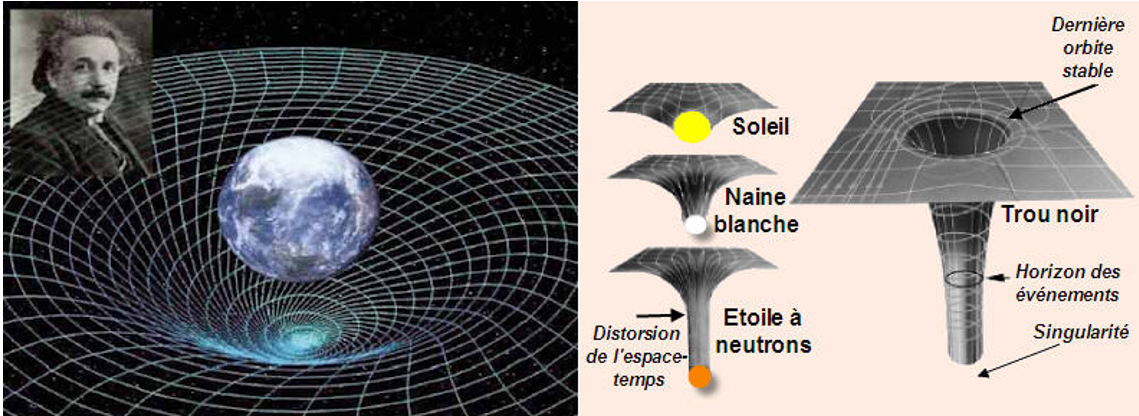

Figure 10 Extrait d’une conférence « Mesurer les déformations de l’espace-temps avec la déviation de la lumière » Camille Bonvin et Nastassia Grimm. 23 Décembre 2023, GENEVA

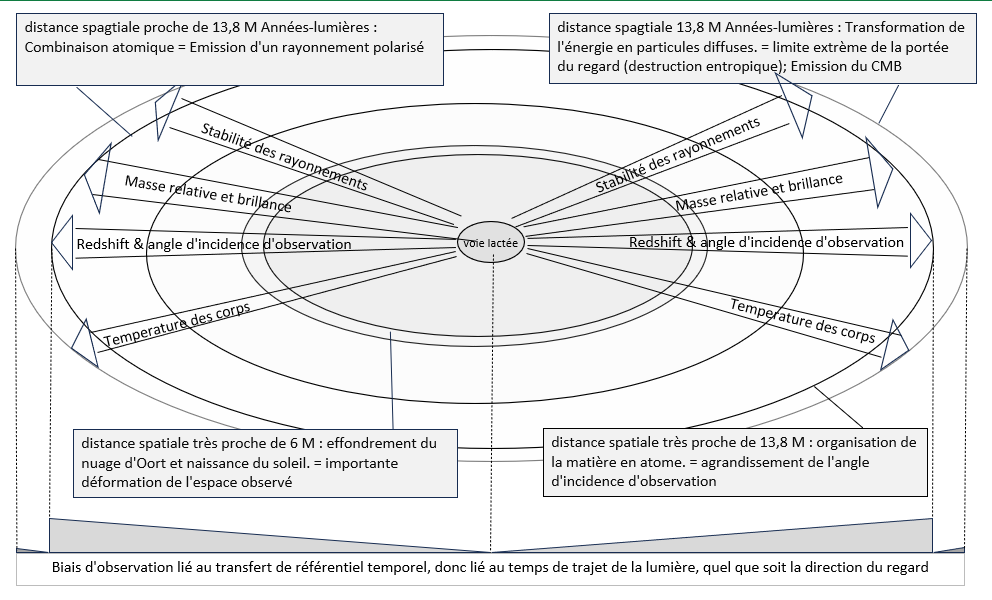

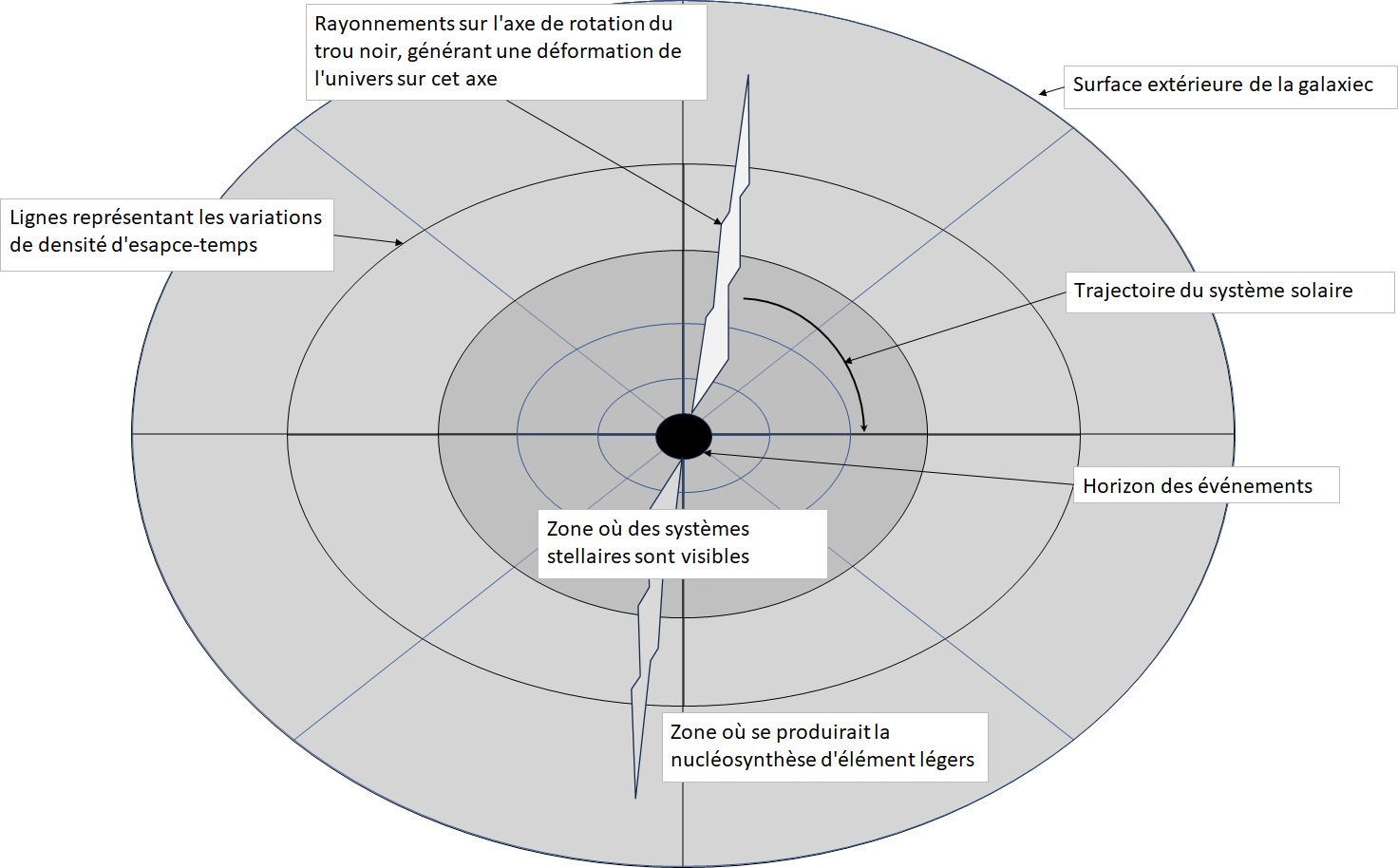

Figure 11 Illustration de l'auteur, portée du regard

Figure 12 public.planck.fr/résultats/221-le-ciel-vu-par-planck-en-couleur, 10 déc. 2013

Figure 13 : Images Bing : à gauche une représentation de l’espace -temps courbé par la présence de la terre, à droite une représentation de l’espace -temps courbé par des corps plus massifs, étoiles à neutrons et trous noirs

Figure 14 Trou noir supermassif : un quasar naissant observé par Alma, Futura science 31 LAURENT SACCO mars 2020

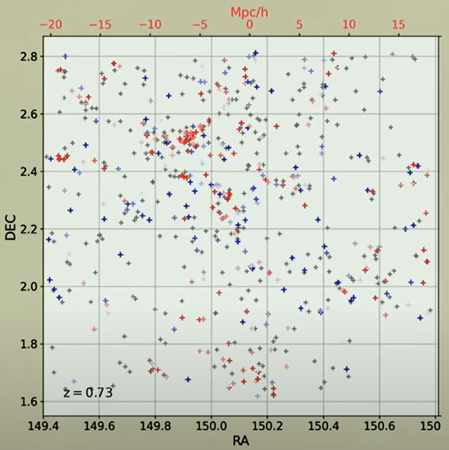

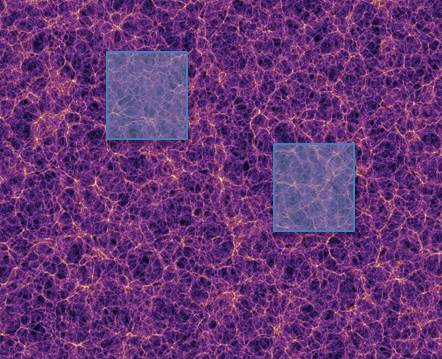

Figure 15 Vue d’un champ d’observation de l’Univers. Conférence à l’Institut astronomique de Paris, La 5e nuit de l’astronomie de l’IAP, « Modéliser l’univers sur un ordinateur ». 17 juin 2023

Figure 16 : 1 : Conférence IPR Françoise COMBES 2 mai 2017, 2 : Pourquoi la formation des galaxies est-elle inefficace ? Pierre Guillard (IAP) 4 Avril 2023

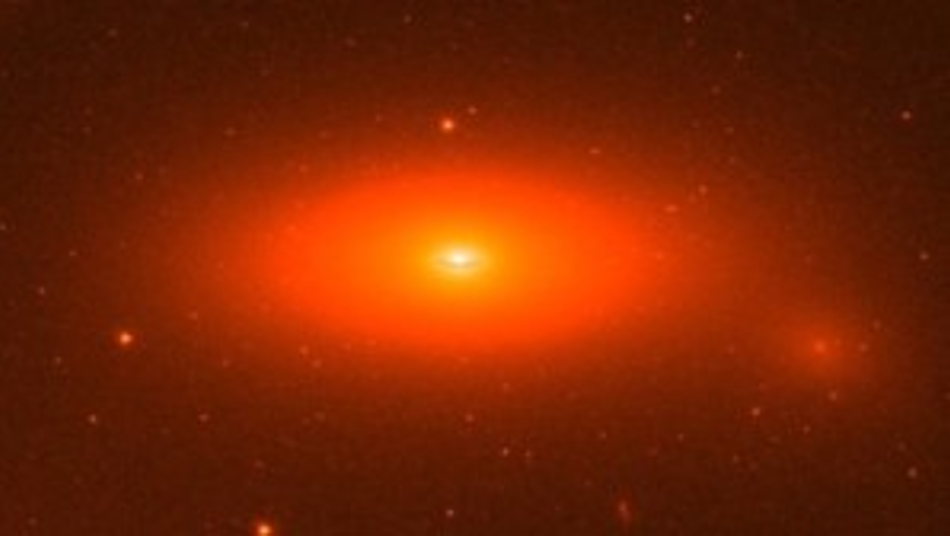

Figure 17 NGC 1277, image Hubble space Tlescope / Nasa

Figure 18 : Dans cette simulation, où chaque point est une galaxie, l’univers apparaît avec une structure filamentaire à grande échelle. (Https://irfu.cea.fr/Phocea/Vie_des_labos/Ast/ast.php?id_ast=3859, 18 janvier 2017)

Figure 19 Cette vue d’artiste (qui n’est pas à l’échelle) illustre la trajectoire du sursaut radio rapide FRB 20220610A, Par Jean-Baptiste Jacquin. Publié le 24 octobre 2023 à 19h00

Figure 20 Illustration de l'auteur

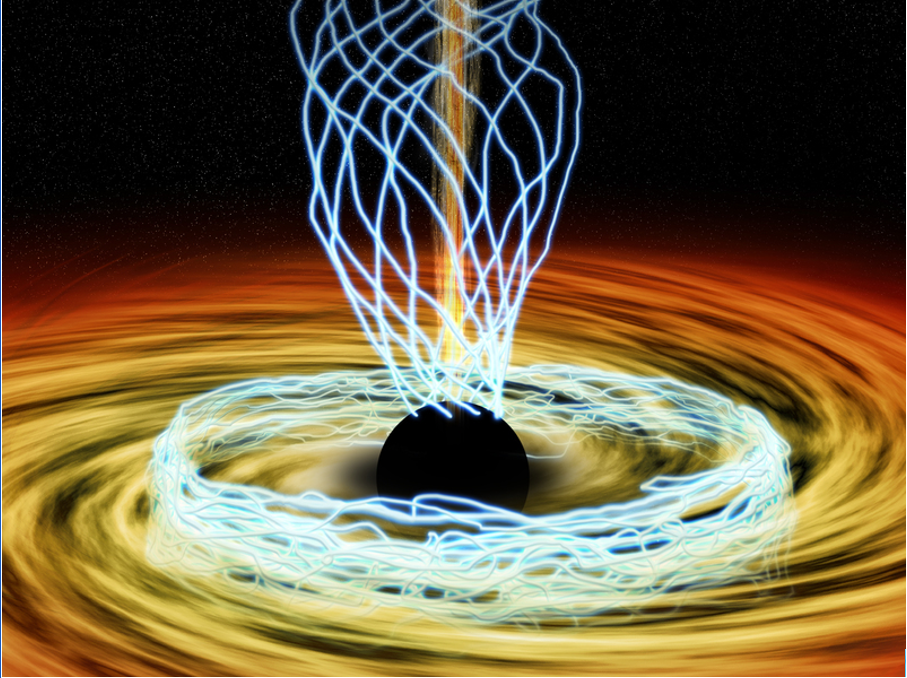

Figure 21 « Observation inédite du magnétisme de Sgr A*, trou noir central de notre galaxie » Ça se passe là-haut, 4 déc. 2015

Figure 22 : Forces de Casimir sur des plaques parallèles

Figure 23 Conférence à l’IAP, « Modéliser l’univers sur un ordinateur ». Samedi 17 Juin 2023. Extrait choisi de cette conférence.

Figure 24 Nasa, ESA, The Hubble Heritage. NGC 1068. Futura-science, le 11 déc. 2019

Figure 25 Extrait de conférence, Institut d’astrophysique de Paris, avril 2023

Figure 26 « Espace de Minkowski », Wikipédia, 11 novembre 2023

Figure 27 Vue des objets lointains du système solaire, au-delà des huit planètes connues, image extraite d’un article de national géographique de Nadia Drake

Figure 28 Des astronomes découvrent une nouvelle galaxie « quasi sombre ». Sciencepost, le 26 octobre 2023, 16 h 04 min

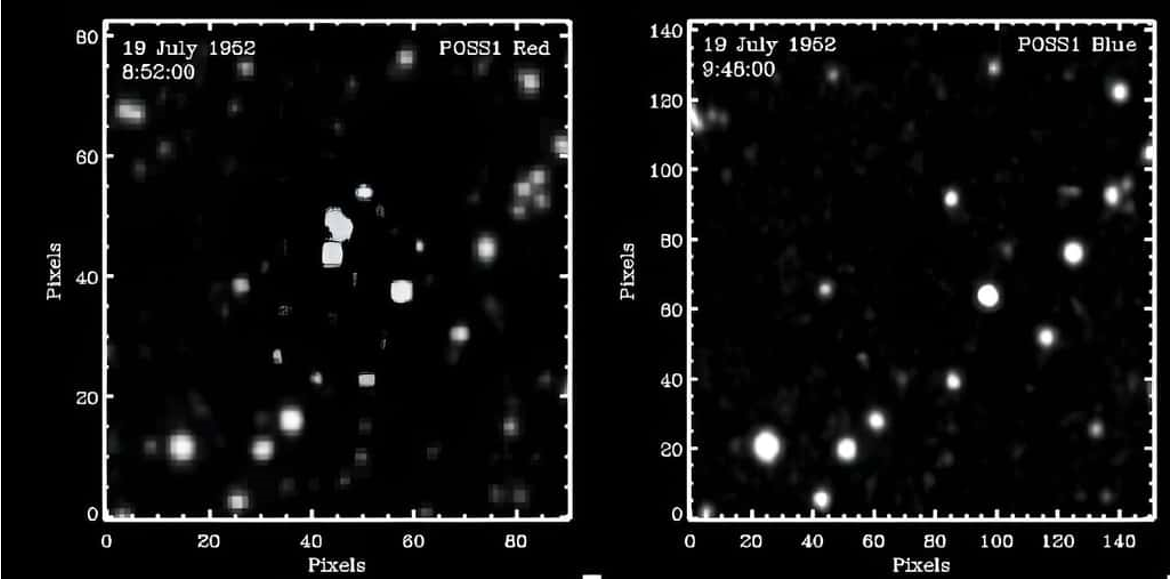

Figure 29 photographiques de 1952. © PALOMAR OBSERVATORY/SOLANO, ET AL, futura-sciences.com/sciences/actualites/astronomie

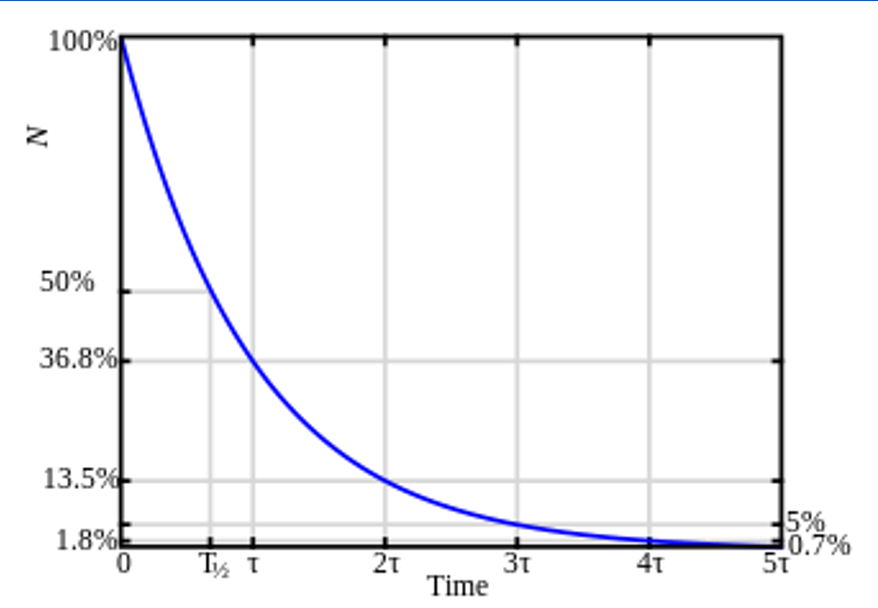

Figure 30 https://fr.wikibooks.org/wiki/Le_noyau_atomique/La_loi_de_désintégration_radioactive

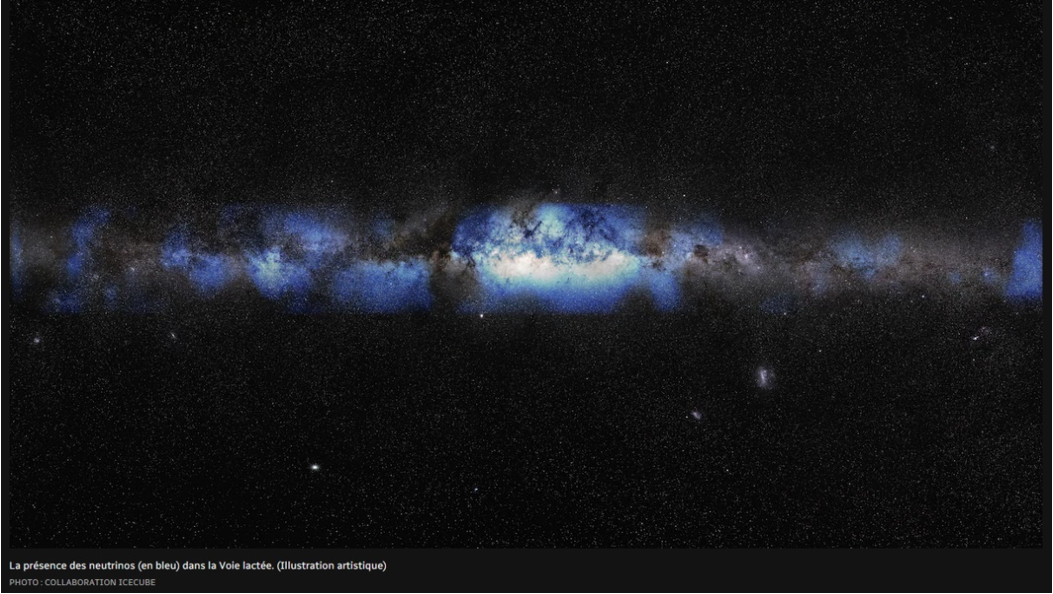

Figure 31 Illustration artistique « Des neutrinos provenant du centre de la Voie lactée détectés pour la première fois » Source : Radio-Canada.ca, 12 juillet 2023

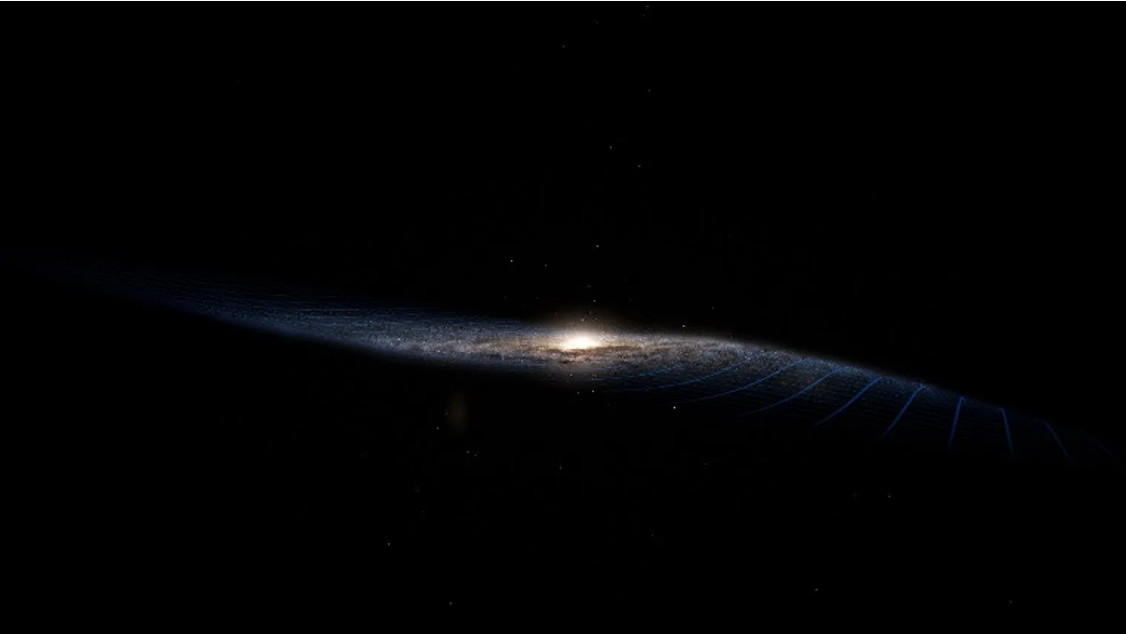

Figure 32 Visualisation de la déformation latérale apparente. Source : Techno-Science.net actualité/matière-noire-déforme-considérablement-notre-galaxie, le 04/10/2023

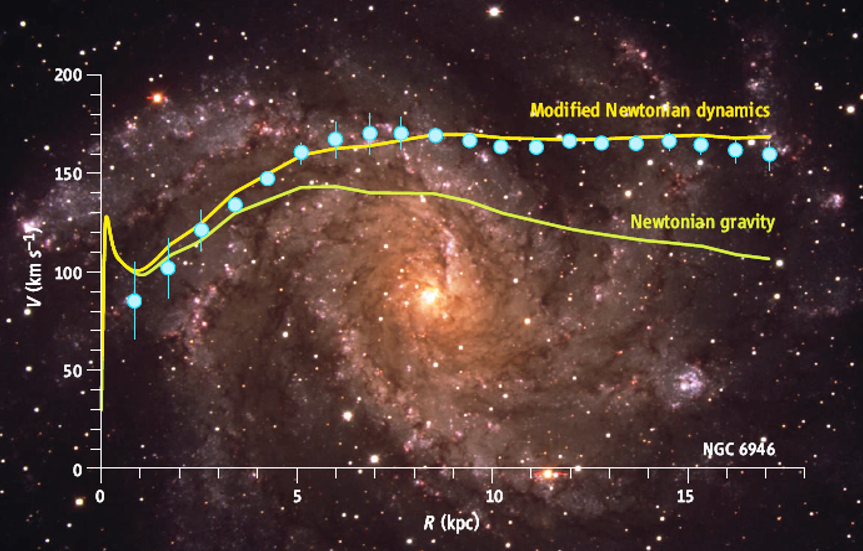

Figure 33 Vitesse de rotation des étoiles dans la galaxie spirale NGC 6946 en fonction de leur distance (en Mpc). Source : Futura-science.com le 05/10/2012

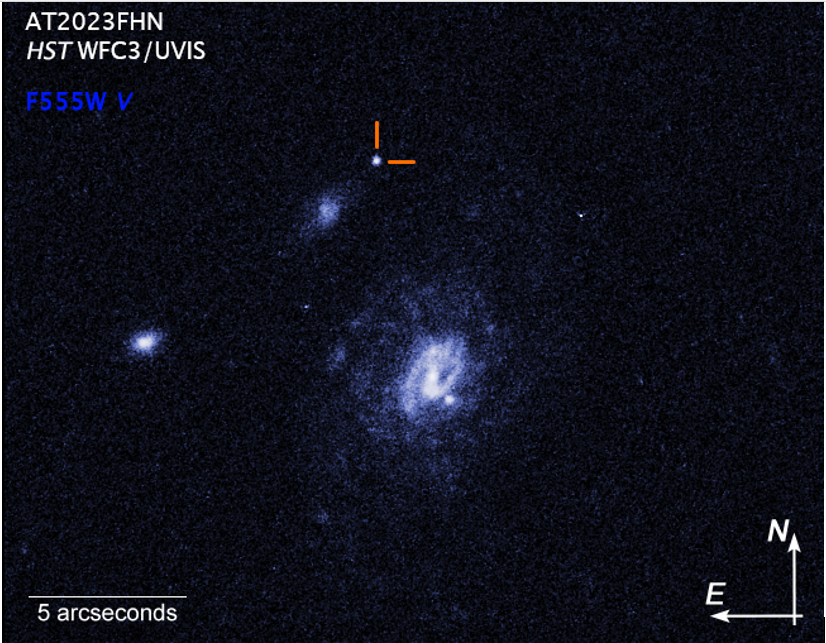

Figure 34 image du télescope Hubble du transitoire optique bleu rapide lumineux (LFBOT) AT2023FHN, HUBBLESITE, 5 October 2023

Figure 35 Nébuleuse d'Orion, David Duarte Astrophotographie

Figure 36 © NASA, ESA, CSA, A. Levan (Université Radboud) 24 novembre 2023

Figure 37 © NASA, ESA, CSA, Joseph Olmsted (STScI)39 24 novembre 2023

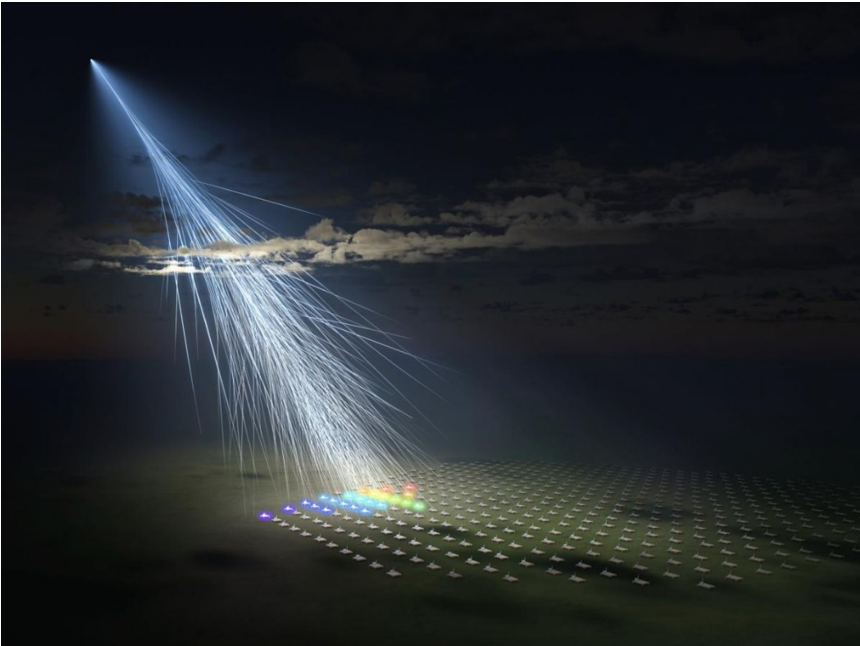

Figure 38 En entrant dans l'atmosphère, la particule provoque des réactions en chaine détectées par le Telescope Array aux Etats-Unis

SIMON SINGH, Le roman du big bang, Edition Pluriel, Juillet 2011

Glazebrook, Karl, Nanayakkara, Themiya, Schreiber, A massive galaxy that formed its stars at z∼11 ARXIV [2308.05606], fevrier 2024

EVRARD-OUICEM ELJAOUHARI, LE JOUR ou l’univers à basculé, Ciel & espace no 590, août-septembre 2023

ANDREW PONTZEN, How redshift colours our view of the history of the universe, NewScientist, 14 OCTOBRE 2015

BRICE LOUVET, Qu’est-ce que le fond diffus cosmologique, et pourquoi est-il aussi important, Science post, 7 juillet 2023.

FABRICE NICOT, Comment-se-sont-formes-les-trous-noirs-les-plus-massifs-de-l-univers, Science et avenir, le 11.03.2021.

FELIPE ASENJIO, Electromagnetic redshift in anisotropic cosmologies, ARXIV [1801.05472], 2018/01/16

DANIEL WHALEN, radio emission from a $z =$ 10.3 Black Hole in UHZ1, ARXIV [2308.03837], 11 Sep 2023

LAURENT SACCO, Trou noir supermassif : un quasar naissant observé par Alma, Futura science, 31/03/2020

ADRIEN, Des astronomes détectent d’inexplicables sursauts radio, Techno-Science.net, 28/10/2023

Jean-Baptiste Jacquin, Un sursaut radio rapide vieux de 8 milliards d’années, LE MONDE, 24 octobre 2023

DONALD PELLETIER ET AL., NGC1277 galaxie lenticulaire située dans la constellation de Persée WIKIPEDIA, 7 janvier 2024

M. Johnson et al., Observation inédite du magnétisme de Sgr A*, trou noir central de notre galaxie, Ça se passe là-haut, 4 déc. 2015

Nathalie Mayer, Les champs magnétiques façonnent les galaxies spirales comme la Voie lactée, Futura Science, 11 déc. 2019

Henri Poincaré et al, Espace de Minkowski », Wikipédia, 11 novembre 2023

Geraint Lewis, Dans les premiers temps de l'Univers, le temps paraît s'écouler cinq fois plus lentement, GEO AVEC AFP, le 09/07/2023

Fabrice Nicot, Découverte de l'écho d'un festin cosmique datant de 200 ans, Sciences et avenir, le 21.06.2023

Brice Louvet, Des astronomes découvrent une nouvelle galaxie « quasi sombre », Sciencepost, lE 26 octobre 2023

Brice Louvet, Les premières galaxies de l’Univers sont étonnamment brillantes, Sciencepost, 10/11/2023

collaboration Planck, UN REGARD VERS L’ORIGINE DE L’UNIVERS, PUBLIC.PLANCK, le 11 janvier 2011

Mewtow, Le noyau atomique/La loi de désintégration radioactive, WIKIBOOKS.ORG, 14 decembre 2023

ALAIN LABELLE, Des neutrinos provenant du centre de la Voie lactée détectés pour la première fois, RADIO-CANADA, 12 juillet 2023

ADRIEN, La matiere-noire-deforme-considerablement-notre-galaxie, Techno-Science.net, le 04/10/2023

Théorie Mond : qu'est-ce que c'est ? FutuRA SCIENCE le 05/10/2012

Ashley Chrimes, AT2023fhn (le pinson) : transitoire optique rapide bleu à grande distance de sa galaxie hôte, ARXIV [2307.01771] le 3 octobre 2023

article inspiré des travaux de Kenzo Ishikawa, Interactions neutrino-photons : percer les mystères de la physique des particules, ISSUES.FR, Septembre 2023

ADRIEN, Une enveloppe à la température inimaginable entoure notre galaxie: d'où vient-elle ?, Techno-Science.net, le 21/12/2024

La Crédibilité de la théorie du big bang » Hubert Reeves, 21 nov. 2014

L'Avenir de la vie sur Terre », Hubert Reeves, Le 27 avril 2017

LA théorie de la relativité restreinte, SCIENCE étonnante, 2018

LA relativité générale, SCIENCE étonnante, 2019

Expansion de l’Univers et controverse cosmologique », Louise Breuval 17 nov 2022

Conférence à l’Institut astronomique de Paris, « Un Univers synthétique à la rescousse pour comprendre le nôtre, à l'ère du JWST et de Euclid » Clotilde Laigle, 17 Juin 2023

Pourquoi la formation des galaxies est-elle inefficace. Pierre Gaillard (IAP) 4 avril 2023

Conférence à l’IAP, « Modéliser l’univers sur un ordinateur ». Samedi 17 juin 2023

Les galaxies primordiales avec le télescope James Webb ». Société astronomique de France, Mercredi 8 février 2023 à 19h

Mesurer les déformations de l'espace-temps avec la déviation de la lumière, COSMIC BLUESHIFT, UNIVERSITE DE GENEVE, SEPTEMBRE 2023

Modèle de cosmologie offrant des conclusions plus cohérentes et convaincantes.

Informations basées sur les observations du télescope JWST de pointe.

Une approche réfléchie aux paradoxes cosmologiques pour un modèle plus solide.

La cosmologie de l'entropie cyclique est un modèle cohérent basé sur les observations cosmiques et la résolution des paradoxes.

Les observations du télescope JWST ont contribué à l'élaboration de ce modèle cosmologique.

Vous pouvez contacter Alain-Gilles Delatorre par téléphone au +33624781070 ou par email à alaingilles.delatorre@laposte.net.

Le cosmologue indépendant Alain-Gilles de la TORRE est basé au 3 Rue De la Justice Pourpre à Cergy, 95000

Oui, ce modèle de cosmologie offre des conclusions plus cohérentes sur des paradoxes cosmologiques établis.

Ce modèle fournit une perspective novatrice sur l'entropie cyclique et ses implications cosmologiques.